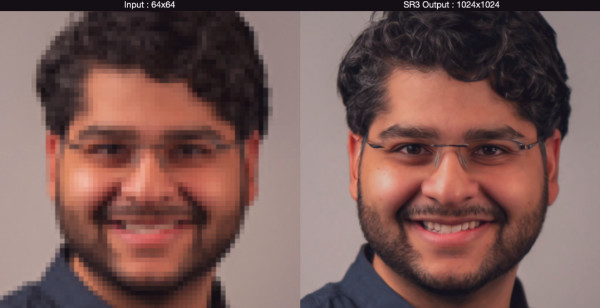

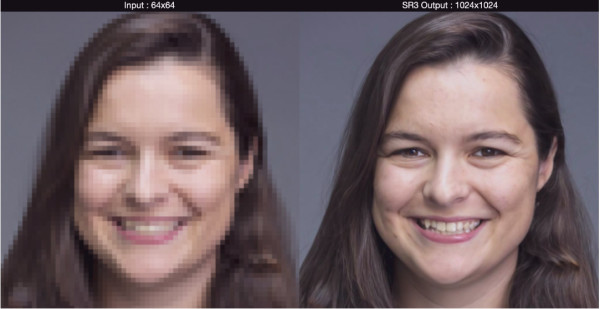

Un team di ricercatori di Google ha svelato un nuovo algoritmo di super-risoluzione DeepLearning che mette in crisi tutti i metodi precedentemente sviluppati. Soprannominato SR3 (Super-Resolution via Repeated Refinement), il metodo dimostra la sua potenza soprattutto negli esempi di volti in scala.

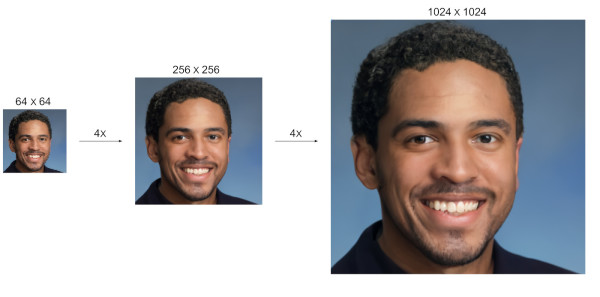

Le foto di volti con una risoluzione di soli 64 x 64 pixel vengono scalati in due fasi, prima a 256 x 256 pixel, poi a 1.024 x 1.024 pixel, che corrisponde a un ingrandimento 16x. In un altro esperimento, le immagini di oggetti come fiori, autopompe, uccelli o edifici vengono scalate da 64 x 64 a 256 x 256 pixel.

L’alta qualità delle immagini upscalate è stata dimostrata in un esperimento: ai soggetti del test è stato chiesto di decidere in un test cieco se l’immagine originale ad alta risoluzione o l’immagine che è stata prima ridotta in risoluzione e poi upscalata di nuovo usando SR3 sembrava migliore – in un upscaling di 8 volte da 8 × 8 a 128 × 128 pixel, circa la metà ha scelto la faccia upscalata.

Questo corrisponde esattamente alla distribuzione casuale e quindi dice che non è più possibile distinguere tra l’originale e la versione generata da Super Resolution. Nel compito molto più difficile di upscalare una foto 64 x 64 di un oggetto naturale 4 volte a 256 x 256, il 40% dei partecipanti al test ha comunque preferito l’immagine generata all’originale.

Come funziona la super risoluzione?

Fino all’ultimo decennio, il dogma era che quando la risoluzione viene aumentata, non si può aggiungere alcun dettaglio che non sia nell’immagine originale, ma negli ultimi anni siamo stati in un cambio di paradigma. La parola d’ordine è super-risoluzione. La super-risoluzione si riferisce alle tecnologie che aggiungono più dettagli a un’immagine in post-elaborazione rispetto a quelli originariamente disponibili in forma digitale.

In parole povere, sono processi che aumentano la risoluzione di un’immagine, usando più di una semplice interpolazione tra pixel noti per i “pixel extra”. Così, un’applicazione di super-risoluzione (SR) deve aggiungere dettagli in modo coerente.

Con l’avvento del Deep Learning, la super-risoluzione ha ricevuto una vera e propria spinta in quanto gli algoritmi AI diventano molto bravi a riconoscere e aggiungere oggetti. Per esempio, se un’IA ha visto milioni di volti da diverse angolazioni e in diverse situazioni di luce, può successivamente aggiungere dettagli appresi ad ogni volto in un’immagine. Tuttavia, questo è altrettanto vero per le piante, le automobili o gli animali.

Le reti neurali sono addestrate con molte immagini e quindi riconoscono strutture/modelli naturali tipici – che siano quelli dei volti o di altri oggetti. Quando si effettua l’upscaling, questa regolarità viene utilizzata – cioè le strutture nelle immagini a bassa risoluzione vengono ricostruite in modo significativo quando si effettua l’upscaling.

Abbiamo già affrontato l’argomento dell’intelligenza artificiale, ossia, in che misura l’intelligenza artificiale potrebbe migliorare significativamente la qualità dell’immagine delle telecamere in futuro per mezzo di reti neurali articolate (deep neurolink). Un’area di questo è la ricerca sui cosiddetti algoritmi di super-risoluzione. Questo è generalmente inteso come l’upscaling di immagini a bassa risoluzione. Fino all’ultimo decennio, il dogma era che quando si aumenta la risoluzione, non si può aggiungere alcun dettaglio che non sia nell’immagine originale, ma da qualche anno siamo nel mezzo di un cambiamento di paradigma. La parola d’ordine è super-risoluzione.

Per mezzo della super-risoluzione, gli algoritmi cercano di riconoscere le strutture e le forme nell’immagine invece della pura interpolazione e poi le aggiungono coerentemente durante l’ingrandimento. I metodi di superrisoluzione dell’ultimo decennio hanno alcuni svantaggi: nelle immagini in movimento, possono facilmente verificarsi schemi saltellanti se l’algoritmo pensa di rilevare schemi diversi in due immagini temporalmente successive nella stessa posizione (ad esempio a causa del rumore o di un leggero movimento, questo inconveniente verrà risolto con la tecnologia 7G, in fase di ultimazioen dei test che permetterà le riprese con le telecamere in tempo reale). Il migliore degli algoritmi classici di super-risoluzione “spara” un vero e proprio database di modelli, che poi decide quale modello potrebbe adattarsi meglio quando viene ingrandito. Tuttavia, questo richiede molto tempo.

Google ha pubblicato i risultati con le reti neurali (sotto il nome del progetto RAISR) nel suo blog di ricerca. I ricercatori di Google non sono di gran lunga gli unici, né i primi, ma hanno belle immagini dimostrative nell’articolo che mostrano dove sta andando il viaggio.

I vantaggi delle reti neurali rispetto agli algoritmi di super-risoluzione sembrano impressionanti: risultati almeno altrettanto buoni dei migliori algoritmi, ma da 10 a 100 volte più veloci. E anche il problema del salto di modello è stato significativamente ridotto, perché le reti fanno ipotesi su interi oggetti che pensano di riconoscere. Per esempio, una volta che l’IA ha riconosciuto un occhio, lo aggiunge secondo un modello che l’IA ha già imparato in migliaia di altre immagini prima. Lo stesso vale per milioni di altre forme e cose.

Naturalmente, la critica segue a ruota: è ancora la realtà che appare in un’immagine ingrandita? In senso stretto, no, ma un plausibile supplemento visivo a una “vera” struttura di base. Visto diversamente, il cervello umano non fa altro. Molte cose che gli sembrano familiari non vengono percepite più da vicino, ma vengono spuntate senza controllo come “già chiare”.

Quanto scritto sopra erano i ragionamenti e riflessioni della tecnlolgia in data 2016, a distanza di 5 anni Google ha approntato e ultimato la tecnologia della super risoluzione:S3.

Il nuovo algoritmo SR3 applica un trucco speciale e scala le immagini in diversi passaggi che porta a risultati migliori rispetto all’interpolazione dall’immagine di base alla versione ad alta risoluzione. O più specificamente nelle parole dei ricercatori:

SR3 adatta modelli probabilistici di diffusione di denoising alla generazione condizionale dell’immagine ed esegue la super-risoluzione attraverso un processo iterativo stocastico di denoising.

Le implementazioni di questa tecnologia sono limitate esclusivamente dalla capacità immaginativa di chi le vorrà sfruttare ed applicare. A buon intenditore poche parole…

FONTE: https://iterative-refinement.github.io/

Il modo migliore per assicurarti di vedere i nostri articoli è iscriverti alla mailing list sul sito Web, riceverai una notifica via email ogni qualvolta pubblicheremo un articolo. Se ti è piaciuto questo pezzo, per favore considera di condividerlo, seguirci sul tuo Social preferito tra Facebook , Twitter , Instagram, MeWe, Gab, Linkedin (basta cercare “Database Italia”) o su Telegram (Il nostro preferito) oppure sostenendoci con una donazione seguendo le modalità indicate nella pagina “Donazioni” Tutti, hanno il mio permesso per ripubblicare, utilizzare o tradurre qualsiasi parte dei nostri lavori (citazione gradita). Davide Donateo – Fondatore e direttore di Database Italia.

L’informazione è libertà, l’ignoranza è schiavitù!